在 Windows 上及与 Windows 配合构建智能 AI 体验的能力正在迅速发展。 Windows AI Foundry 在 Windows 11 电脑上提供 AI 支持的功能 APIs 。 这些功能处于活动开发阶段,并随时在后台本地运行。

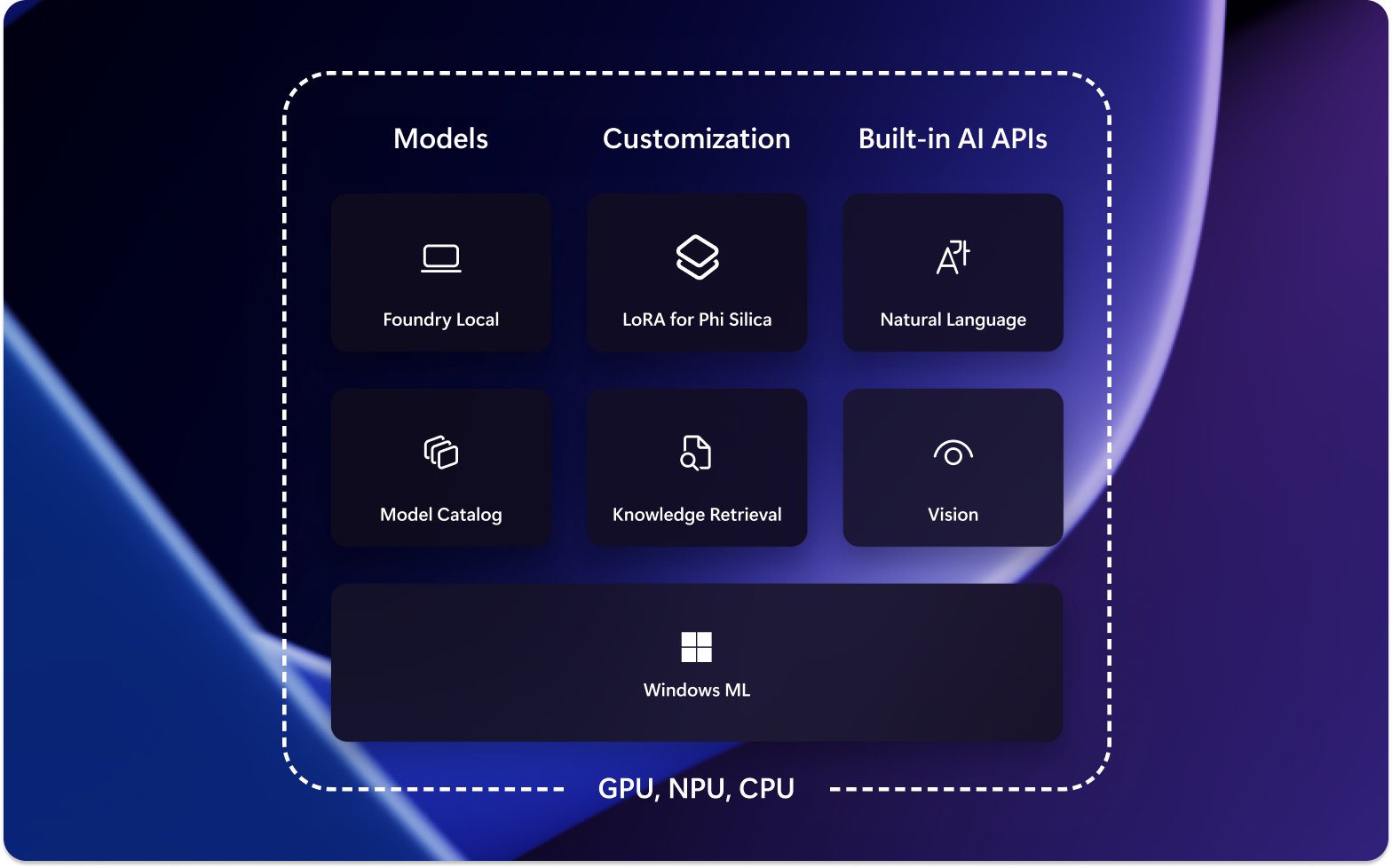

Windows AI Foundry 包括多个可启用独特 AI 体验的组件:

Windows AI APIs:可以使用内置的 Windows AI APIs 为 Copilot+ 电脑上的用户集成 AI 服务。 可从 Windows 应用访问的一些现成 AI 功能包括:

Foundry Local:可以利用并集成到应用中的常用 OSS 模型

Windows ML:使用自己的 ONNX 模型启用 AI 推理

开发工具: Visual Studio AI Toolkit 和 AI 开发库 等工具,可帮助你成功构建 AI 功能

如何在 Windows 应用中使用 AI?

Windows 应用可以利用机器学习(ML)模型增强其功能和 AI 用户体验的几种方法,包括:

- 应用可以使用生成 AI 模型来了解复杂主题,以汇总、重写、报告或展开。

- 应用可以使用模型将自由格式内容转换为应用可以理解的结构化格式。

- 应用可以使用语义搜索模型,允许用户通过含义搜索内容并快速查找相关内容。

- 应用可以使用自然语言处理模型来推理复杂的自然语言要求,并规划和执行作来完成用户的要求。

- 应用可以使用图像作模型智能修改图像、擦除或添加主题、纵向扩展或生成新内容。

- 应用可以使用预测诊断模型来帮助识别和预测问题,并帮助指导用户或为其执行此作。

使用 Windows AI APIs 相较于使用自带的模型

使用 Windows AI APIs

当本地 AI 模型是正确的解决方案时,可以使用 Windows AI APIs 为 Copilot+ 电脑上的用户集成 AI 服务。 这些 APIs 是内置在您的电脑上的,能够启用由 AI 驱动的独特功能,同时资源消耗相对较小。

训练自己的模型

如果你有能力使用自己的私有数据在 TensorFlow 或 PyTorch 等平台上训练自己的模型。 可以使用适用于 Visual Studio Code 的 ONNX Runtime 和 AI Toolkit 在本地在设备硬件上运行该自定义模型,将其集成到 Windows 应用程序中。

AI Toolkit for Visual Studio Code 是一种 VS Code 扩展,可用于在本地下载和运行 AI 模型,包括通过 DirectML 访问硬件加速以提高性能和进行缩放。 AI Tookit 还可以帮助你:

- 使用 REST API 在直观的测试环境或应用程序中测试模型。

- 微调 AI 模型(在本地或云中)以创建新技能,提高响应的可靠性,设置响应的基调和格式。

- 微调流行的小型语言模型(SLM),如 Phi-3 和 Mistral。

- 将 AI 功能部署到云或使用在设备上运行的应用程序。

- 使用 DirectML 利用硬件加速提高 AI 功能的性能。 DirectML 是一种低级别 API,使 Windows 设备硬件能够使用设备 GPU 或 NPU 加速 ML 模型的性能。 将 DirectML 与 ONNX Runtime 配对通常是开发人员大规模为用户带来硬件加速 AI 的最直接方法。 了解详细信息:DirectML 概述。

- 使用模型转换功能量化和验证用于 NPU 的模型

你可能还想要了解这些模型微调概念,调整预先训练的模型以更好地适应数据。

使用云 AI 模型

如果使用本地 AI 功能并不是正确的路径, 那么使用云 AI 模型和资源 可能是一种解决方案。

其他 AI 功能

Windows 上的应用操作:为应用创建操作,为用户启用新的和独特的 AI 功能

Recall 利用 AI 来帮助你找到在电脑上看到的任何内容。 单击“执行”是一项 AI 支持的功能,用于将操作连接到Recall找到的内容(文本或图像)。

Windows Studio Effects 使用 AI 将特殊效果应用于设备摄像头

使用负责任的 AI 做法

每当在 Windows 应用中集成 AI 功能时,我们强烈建议你遵循在 Windows 上开发负责任的生成式 AI 应用程序和功能指南。